|

|

| J Navig Port Res > Volume 46(3); 2022 > Article |

|

요 약

본 연구에서는 인공지능을 활용한 영상분석 기술을 통해 영상 내의 월파를 실시간으로 감지하고 처오름 높이를 산정하는 기술을 제안하였다. 본 연구에서 제안한 월파 감지 시스템은 실시간으로 악기상 및 야간에도 월파를 감지할 수 있음을 확인하였다. 특히, 합성곱 신경망을 적용하여 실시간으로 CCTV 영상에서 파랑의 처오름을 감지하고 월파 여부를 판단하는 여과 알고리즘을 적용하여 월파의 발생 감지에 대한 정확성을 향상시켰다. AP50을 통해 월파 감지 결과의 정확도는 59.6%로 산정되었으며, 월파 감지 모델의 속도는 GPU 기준 70fps로 실시간 감지에 적합한 정확도와 속도를 보임을 확인하였다.

ABSTRACT

The purpose of this study was to propose technology to detect the wave in the image in real-time, and calculate the height of the wave-overtopping through image analysis using artificial intelligence. It was confirmed that the proposed wave overtopping detection system proposed in this study could detect the occurring of wave overtopping, even in severe weather and at night in real-time. In particular, a filtering algorithm for determining if the wave overtopping event was used, to improve the accuracy of detecting the occurrence of wave overtopping, based on a convolutional neural networks to catch the wave overtopping in CCTV images in real-time. As a result, the accuracy of the wave overtopping detection through AP50 was reviewed as 59.6%, and the speed of the overtaking detection model was 70fps based on GPU, confirming that accuracy and speed are suitable for real-time wave overtopping detection.

해안선은 크게 자연해안과 인공해안으로 구분되며, 우리나라에서 인공해안은 전체 해안선 중 총 51.4%(3,982.4km)로 연안개발이 지속적으로 증가함에 따라 자연해안의 비중이 꾸준히 감소하고 있다(Coast Portal, https://coast.mof.go.kr). 최근에는 경관이 우수한 연안역을 중심으로 주거 및 상업지역이 활발하게 개발되고 있어 인공해안이 급격하게 증가하고 있으며, 연안역에서는 해수면 온도상승에 따른 태풍 규모 및 강도 증가로 인해 연안으로 내습하는 고파랑의 발생빈도가 지속적으로 증가하고 있다. 이러한 고파랑의 내습에 따라 Fig. 1에 보인 바와 같이 호안의 마루를 넘는 월파수괴에 의한 연안역의 피해도 급증하고 있는 실정이다. 이와 같은 연안역의 피해증가와 사회적 관심에도 불구하고 월파에 의한 피해는 재해범 주에 포함되지 못해 구체적인 통계자료가 생산되지 않고 있다(MOIS, 2020).

특히, 월파는 호안구조물 형상, 내습파랑 조건, 구조물 전면의 지형조건 등 다양한 물리적·환경적 변수에 크게 의존하기 때문에 실해역에서 월파를 직접적으로 모니터링하기 위해서는 적지 않은 시간과 비용이 요구된다. 유럽에서는 다양한 호안에 대한 월파량 데이터베이스 구축을 위해 CLASH(Crest Level Assessment of coastal Structures by full scale monitoring, neural network prediction and Hazard analysis on permissible wave overtopping) 프로젝트(De Rouck et al., 2001, 2009)를 진행하여 163개의 테스트 결과로부터 총 10,532개의 월파량 데이터베이스를 구축하였다. 이러한 데이터베이스를 바탕으로 호안구조물의 처오름과 평균월파량 예측을 위한 월파 매뉴얼 EurOtop 2007(Pullen et al., 2007)을 발간하였고, 최근에는 호안의 상대 마루높이 감소에 따른 월파량의 예측정도를 개선한 EurOtop 2018(van der Meer et al., 2018)을 제안하고 있다. 우리나라의 항만 및 어항 설계기준(KDS 64 10 10, MOF, 2020)에서는 Goda et al.(1975)의 연구결과에 기반한 월파량 산정도표를 제공하고 있지만 제한된 실험조건에 의한 산정결과이다. 한편, Goda(2009)는 CLASH 월파 자료에 근거하여 기존의 EurOtop 매뉴얼에서 권장하는 월파량 산정식이 높은 월파량에 대해서는 과대평가를 낮은 월파량에 대해서는 과소평가를 하는 예측의 편향성을 지적하고 새로운 월파량 산정식을 제안하고 있으나 낮은 월파량에 대한 신뢰성을 담보하기 위해서는 수리모형실험 혹은 수치계산을 수행할 것을 권장하고 있다.

월파량 산정을 위해서는 대상 구조물에 대한 실내수리모형실험이 높은 신뢰성을 갖지만 많은 시간과 비용이 요구되며, 낮은 월파량이 발생하는 경우에는 측정오차 및 축척에 따른 효과를 무시할 수 없다. 한편, CFD(Computational Fluid Dynamics)를 활용한 수치모의를 통해 월파량을 산정하는 시도가 증가하고 있지만 수치계산으로부터 산정된 월파량은 격자해상도에 크게 의존되며 상당한 계산비용이 소요되는 단점을 지닌다. 따라서, 해역별로 주요 항만, 산업시설, 상업시설에서 발생되는 월파를 효율적으로 관측하기 위해서는 경제적이고 신속·정확하게 감지할 수 있는 기술이 필요하다.

최근 들어 고해상도 CCTV(Closed-circuit Television) 혹은 휴대용 영상기기로 기록된 영상을 이용하여 실해역에서 발생하는 월파를 직접적으로 관측하려는 시도가 진행되고 있다(Choi and Kim, 2012; Yoon et al., 2017; Chi et al., 2021). 영상기반 월파에 관한 연구들은 영상 내 경계선 검출, 색‧방향 기반 분석 등을 통한 배경 및 객체 분리 등 월파를 단순 탐지하는 영상처리기술에 기초하고 있다. 또한, 영상처리기술을 이용하는 경우 영상에 포함된 잡음에 취약하여 야간 및 악천후에는 관측이 곤란한 문제점이 있다.

본 연구에서는 인공지능(Artificial intelligence)을 활용한 영상분석 기술을 통해 영상 내의 월파를 실시간으로 감지하고 실시간 처오름 높이를 산정하는 기술을 제안한다. 특히, 이미지 처리에 탁월한 성능을 보이는 신경망(Neural network)인 합성곱 신경망(Convolutional Neural Networks, 이하 CNN) 기반의 객체 검출 알고리즘을 활용하여 구조물의 형상이나 내습하는 파랑의 특성을 고려할 필요 없이 신속하게 월파를 감지할 수 있는 기법을 제안한다.

대부분의 딥러닝(Deep learning)은 다양한 인공신경망(Artificial Neural Network, 이하 ANN)을 이용하여 수행되며, 이러한 ANN은 크게 비지도 사전학습 신경망(Unsupervised Pretrained Networks), 합성곱 신경망, 순환 신경망(Recurrent Neural Networks) 및 재귀 신경망(Recursive Neural Networks)으로 분류될 수 있다(Haridas and Jyothi, 2019).

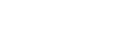

딥러닝 기반의 기계학습(Machine learning)이 비약적으로 발전함에 따라 정지영상 혹은 동영상에서 원하는 이미지(객체)를 자동으로 분류하고 인식하는 연구가 활발히 진행되고 있다. 객체 인식은 영상처리에서 많이 활용되는 기술 중 하나로써 특정 이미지에서 사용자가 원하는 물체를 정도 높게 탐색하고 인식된 객체가 어떠한 의미를 갖는지를 분류하는 기술이다(Girshick et al., 2014). 객체 인식을 위한 도구로는 LeCun et al.(1998)에 의해 제안된 CNN이 가장 널리 활용되고 있다. CNN은 이미지 학습을 위한 신경망을 구성함에 있어서 이미지 데이터의 인접 픽셀 간의 형상(상관관계)이 무시되고 이미지의 벡터화 과정에서 막대한 양의 뉴런이 요구되는 완전연결층의 단점을 보완하기 위해 합성곱 연산을 도입하여 개발된 방법으로 오늘날의 이미지 분류에 있어서 가장 활발하게 사용되는 방법 중 하나이다. CNN은 필터의 합성곱으로 계산되는 연속적인 2개의 합성곱 풀링층(Convolution-pooling layer)과 1개의 완전연결층으로 구성된다. Fig. 2에 일반적인 CNN의 구조를 나타내었다.

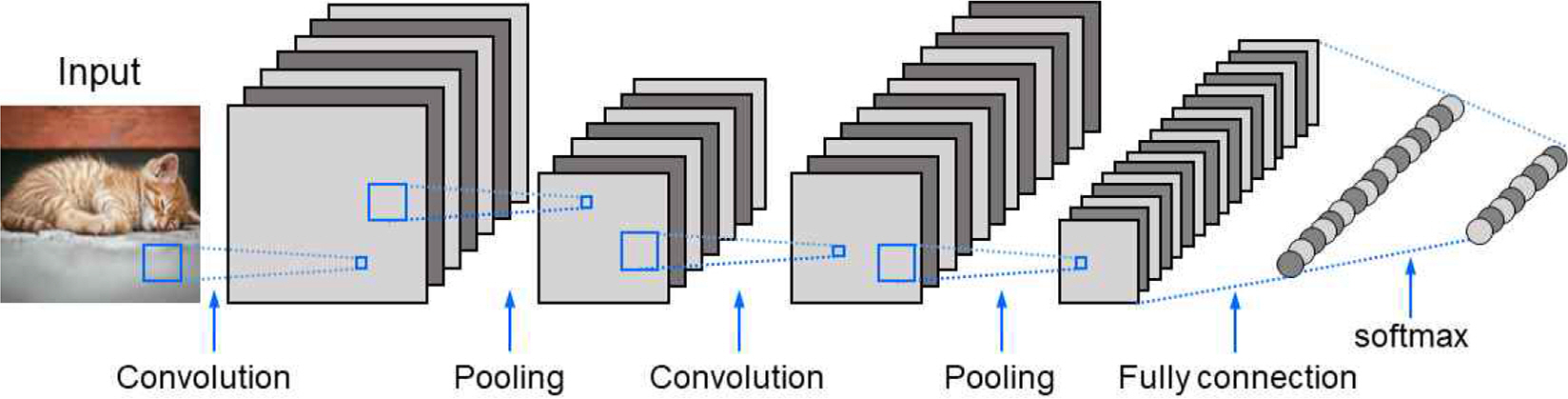

전술한 바와 같이 CNN을 통해 이미지로부터 원하는 객체를 인식하는 문제를 해결할 수 있다. 하지만, 본 연구에서 목표로 하는 월파의 유무와 발생 위치 등을 검출하기 위해서는 이미지에서 객체가 어디에 존재하는지 검출해야 한다. 이러한 객체탐지를 위해 Girshick et al.(2014)은 딥러닝 회귀기법에 기반한 R-CNN(Region-based Convolution Neural Network)을 최초로 제안하였다. R-CNN은 이미지에서 Uijlings et al.(2013)의 선택적 탐색(Selective search) 알고리즘을 이용하여 객체의 후보영역(Region proposal)을 생성하고 CNN을 통해 객체의 특징을 추출한 후에 후보영역 내에서 이미지 분류에는 SVM(Support vector machine)을 이용한다. R-CNN은 후보영역 생성을 통해 이미지 특징을 검출하고 회귀학습 등을 통해 객체를 탐지하는 2-stage 검출이며, 생성된 후보영역이 증가 할수록 객체위치의 검출속도가 느리다는 단점이 있지만 비교적 정확도가 높은 장점을 지닌다. 최근 들어, 객체의 빠른 위치검출을 위해 Redmon et al.(2016)과 Liu et al.(2016)이 각각 제안한 YOLO(You Only Look Once)와 SSD(Single Shot MultiBox Detector) 방법들과 같이 위치탐색과 객체 분류를 동시에 처리하는 1-stage 검출이 활발히 이용되고 있다. Fig. 3에서는 후보영역 생성과 이미지 분류가 순차적으로 일어나는 2-stage 검출과 후보영역 생성과 이미지 분류가 동시에 일어나는 1-stage 검출의 개념을 나타내었다. 본 연구에서는 실시간 월파감지를 위하여 신속한 객체탐지를 위해 1-Stage 검출 방법을 채택하였다.

CNN 기반의 YOLO(Redmon et al., 2016)는 전술한 바와 같이 객체의 위치탐지에 대한 실시간성을 확보하기 위해 하나의 네트워크에서 객체의 위치를 탐색하고 분류한다. YOLO는 공식적으로 4개의 버전(Redmon et al., 2016; Redmon and Farhadi, 2017; Redmon and Farhadi, 2018; Bochkovskiy et al., 2020)이 공개되었으며 저사양의 기기에서 실행하기 위한 Tiny 버전(Redmon and Farhadi, 2018)등이 함께 공개되었다. 객체 탐지 등의 컴퓨터 비전 분야의 이미지 인식향상을 목표로 생성된 COCO 데이터 셋(https://cocodataset.org/)에서 YOLOv3의 정확도는 mAP(mean Average Precision) 55.3이며, 이미지 한 장당 처리속도는 0.018초로 나타난다(Redmon and Farhadi, 2018). 본 연구에서는 속도 대비 높은 정확도를 보이는 YOLOv3 버전을 이용하여 월파를 학습시켜 실시간성을 확보하였다.

다양한 영상을 학습 데이터로 포함시키기 위하여 실제 CCTV 영상과 온라인 월파 동영상으로 CNN의 학습 데이터를 구축하였다. 온라인 월파 동영상 37개와 삼척항과 주문진항에 각각 설치된 해상도 720p의 2018년 10월부터 1년간의 CCTV 영상 28개로 총 65개의 영상(약 5시간 분량, 24만 프레임)을 사용하였다. Fig. 4는 월파에 대한 영상획득을 위해 삼척항과 주문진항에 설치된 CCTV의 위치를 각각 나타내며, CCTV 영상의 화각은 고정되어있다.

수집한 영상으로부터 월파가 발생한 프레임을 분리한 후 월파의 위치를 수동으로 지정하여 약 20,000장의 월파 이미지 데이터 셋을 구축하였다. 데이터 셋에 포함된 월파 프레임에는 악기상과 야간 영상을 포함시켜 다양한 조건에서 월파 영상이 학습되도록 학습 데이터 셋을 구성하였다.

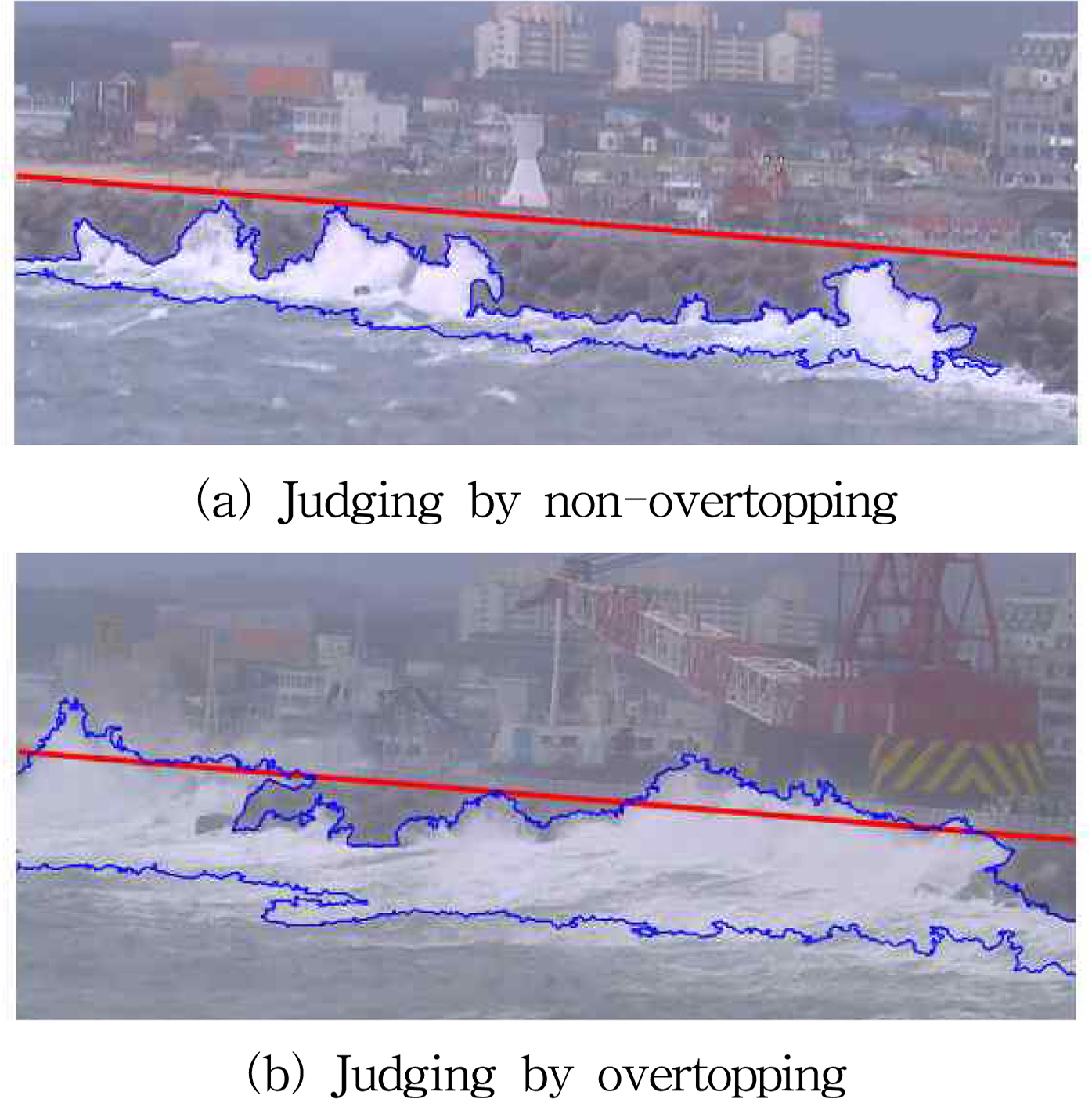

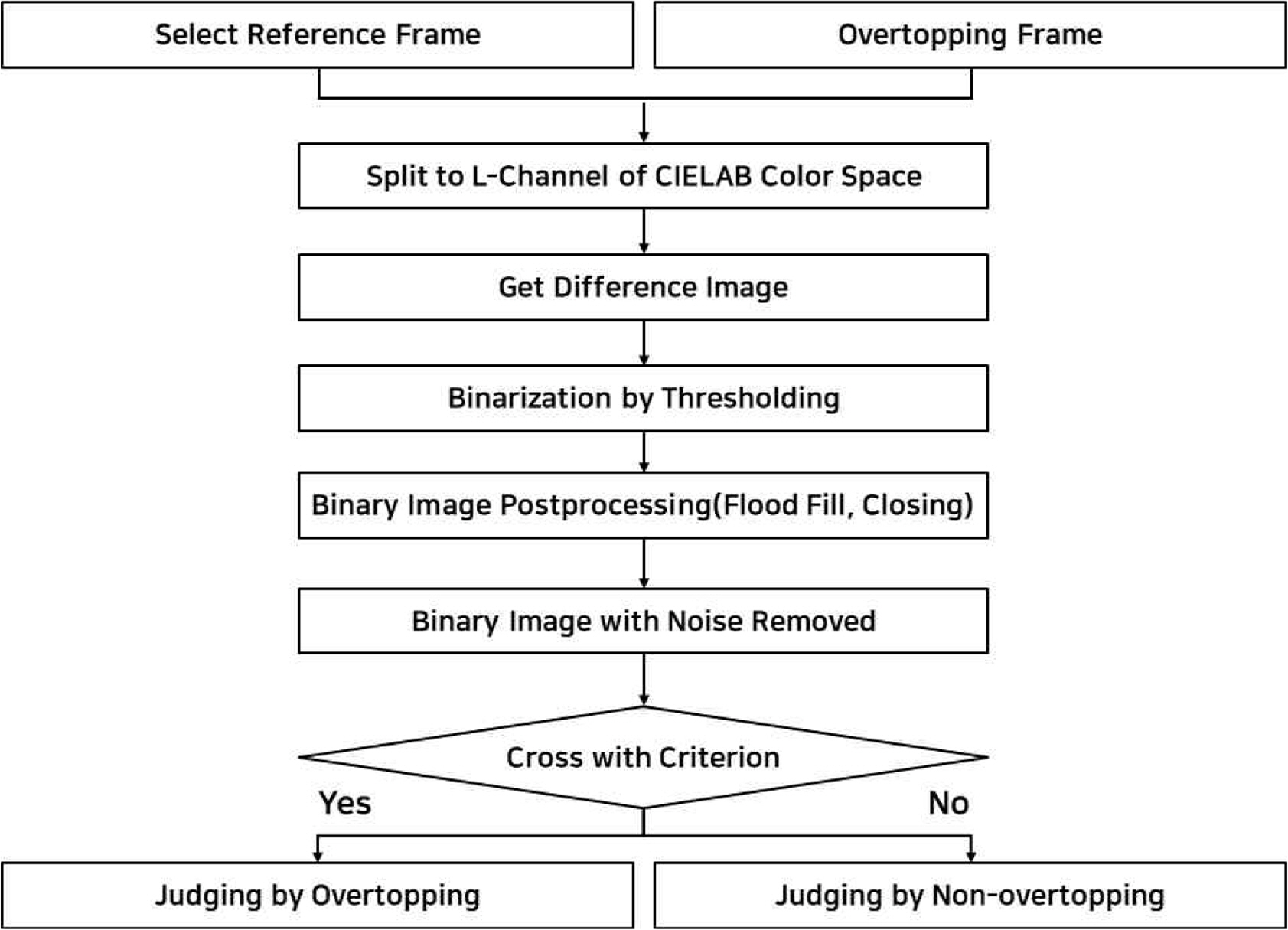

본 연구에서는 월파 발생의 정의를 파고가 구조물의 마루높이를 초과하였을 시점을 월파가 발생하였다고 판단하였다. 객체 검출 알고리즘의 경우 객체의 특징을 추출하여 검출하므로, 파랑이 구조물의 마루높이를 통과하였는지는 파악할 수 없다. 이러한 경우에 있어서 월파 발생에 대한 오검출이 발생하였고, 이를 해결하기 위해 고파랑의 발생영역을 취득하고 구조물 천단과의 교차 여부 판단을 통한 여과 알고리즘을 구축하여 월파 유무 판단에 대한 정확도를 향상 시켰다.

객체탐지 모델을 통한 월파 감지 결과를 Fig. 5에 나타내었다. 하지만, Fig. 5(b)와 같이 구조물의 마루높이를 상회하는 파랑이 발생하지 않은 경우에도 월파로 검출되는 경우가 발생하였다. 이러한 탐지 오류를 해결하기 위해 파랑의 발생 영역을 취득하고 구조물 마루높이와의 교차 여부를 판단하는 여과 알고리즘을 구현하였다.

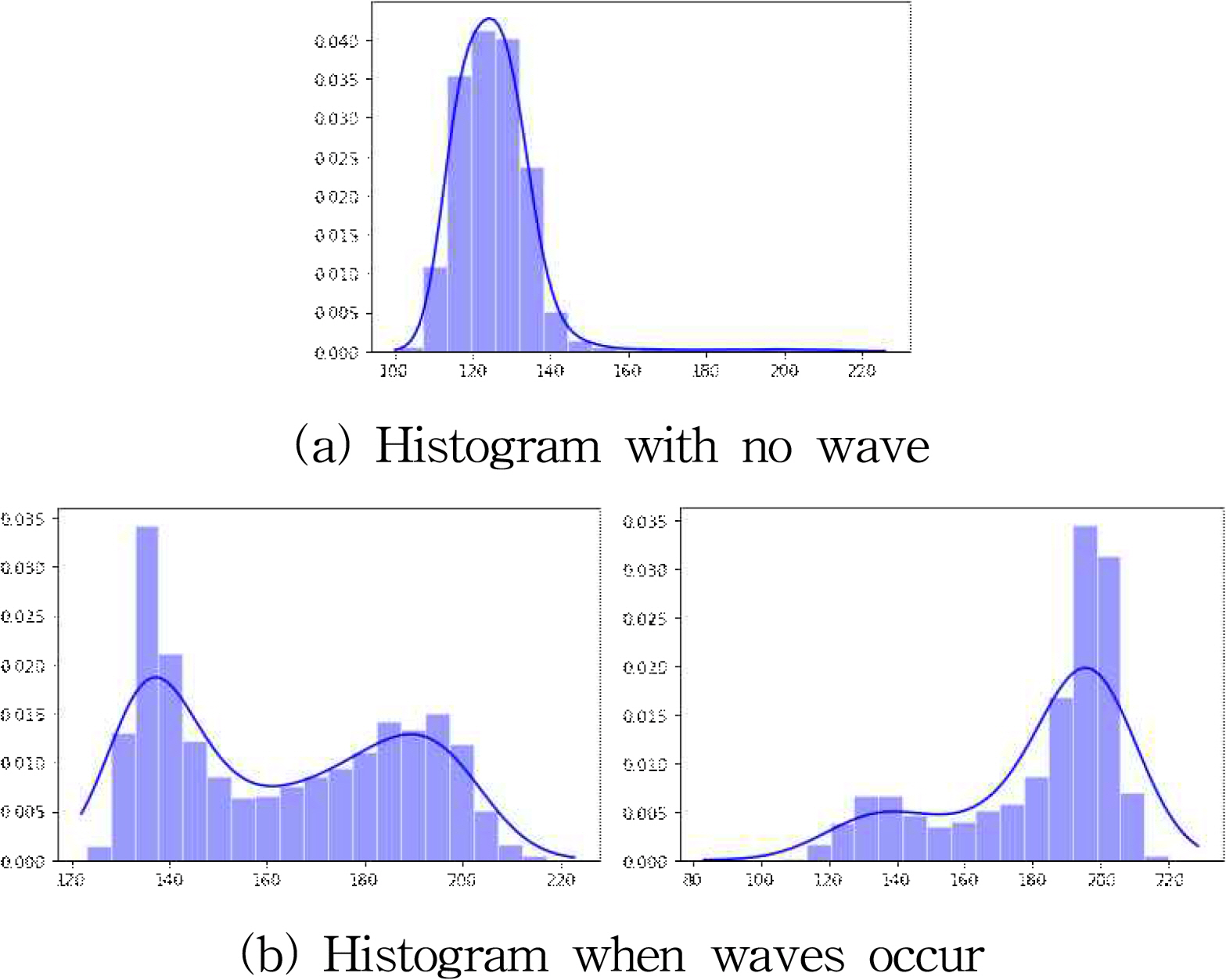

구조물의 마루높이와 비교할 파랑의 발생영역을 산정하기 위해서 우선 파랑의 발생영역이 배경에서 완전히 분리되어야 한다. 파랑의 발생영역을 분리하기 위해 파랑이 발생하지 않고 배경만이 존재하는 기준 프레임을 선정할 필요가 있다. 본 연구에서는 Fig. 6과 같이 영상 내에서 파랑의 발생 여부를 판단하기 위하여 해수면부터 구조물의 마루높이까지를 기준 프레임 선정을 위한 분석 영역으로 지정하였다. 해수 영역은 구조물 마루에 비해 밝은 색상 정보를 가지므로 CIELAB 색 공간의 밝기 채널인 L채널을 통해 파랑의 유무를 분석하였다. Fig. 7에 보인 바와 같이 L채널의 히스토그램을 살펴보면, 파가 발생하지 않을 경우 단봉분포를 나타내며 낮은 영역에서 최빈값이 나타나고, 파가 발생한 경우 히스토그램이 양봉분포 또는 높은 영역에서 최빈값이 나타난다. 본 연구에서는 히스토그램이 단봉분포이고 최빈값이 160아래로 나타날 경우 파가 발생하지 않았다고 가정하였고, 이를 기준 프레임으로 선정하였다.

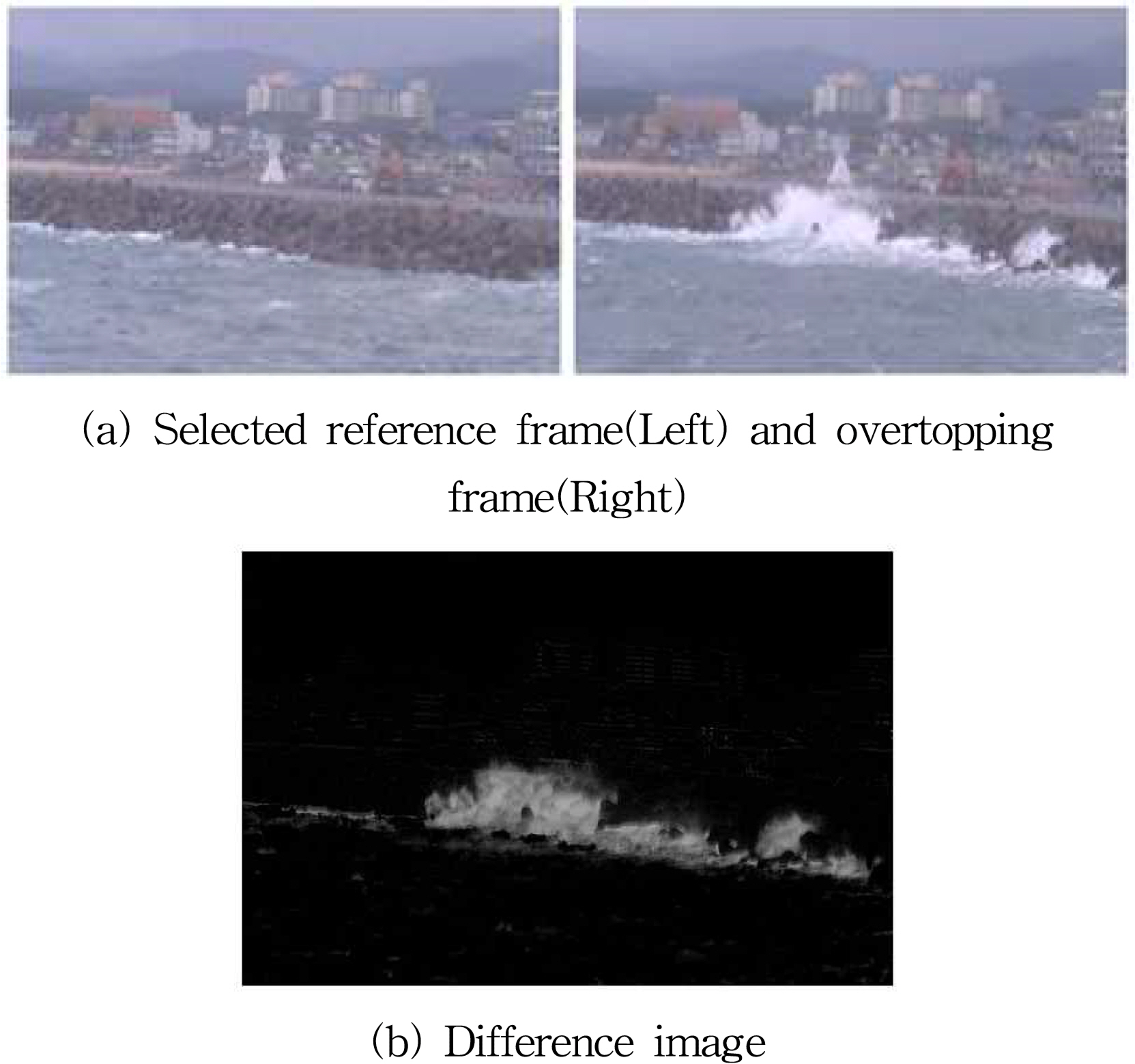

해수 영역은 구조물 마루에 비해 밝은 색상 정보를 가진다는 이미지의 특성을 이용하여 배경 프레임과 파랑이 발생한 프레임을 CIELAB 색 공간에서 밝기의 정보를 갖는 L채널로 분리한 후 두 영상간의 산술연산을 이용하여 Fig. 8과 같은 차분 영상을 취득하였다.

또한, 폭우나 강풍이 동반되는 경우 영상이 다소 흔들리거나, 배경 구조물이 이동하는 경우 노이즈가 발생할 수 있다. 이러한 노이즈를 제거하기 위하여 Fig. 9에 나타낸 바와 같이 차분 영상에서 임계값을 지정하여 이진화 하였다. 취득된 이진영상에서 각 객체의 인접한 픽셀 수를 계산하여 작은 크기의 객체를 제거하였고, 형태학적 연산 중 한 종류인 닫힘 연산과 Fill Hole 알고리즘을 통해 내부 홀들을 제거하였다,

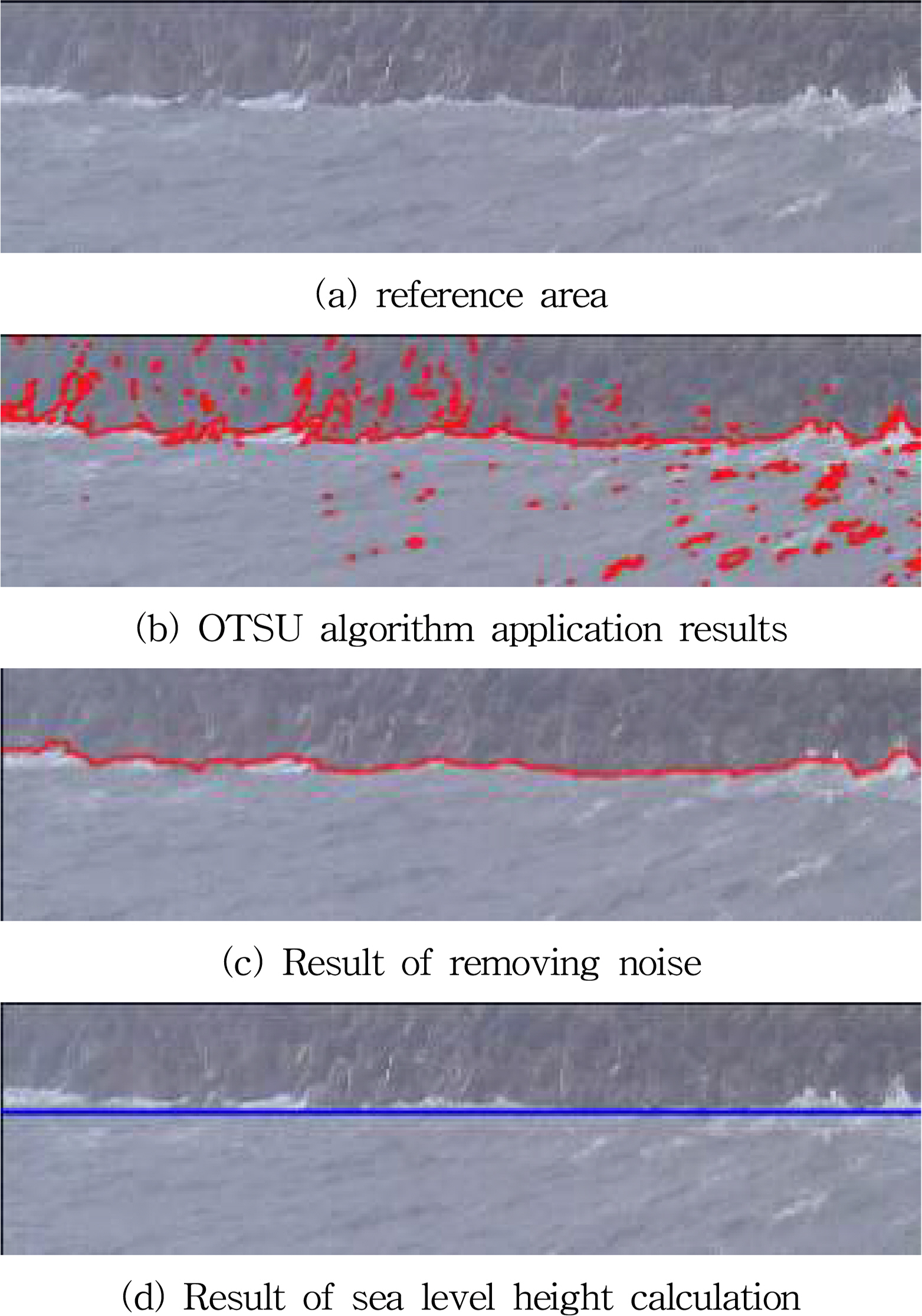

영상에서 처오름 높이를 산정하기 위해서는 해수면으로부터 수위의 최고점을 계산할 수 있어야 한다. 해수면 높이를 자동으로 감지하기 위해 배경 프레임을 이용하여 바다영역에서 소파 블럭까지의 영역을 분리하였다. 해당 영역을 R, G, B 채널로 분리한 후 B채널의 히스토그램을 분석해보면 양봉분포가 나타난다. 이를 OTSU 알고리즘(Otsu, 1979)을 적용하여 임계값을 취득한 후에 해수면과 소파블록 영역을 이진영상으로 분리하였다. 이렇게 분리된 이진영상은 Fill Hole 알고리즘과 형태학적 연산에서 열림 연산을 통해 외부 및 내부 노이즈를 제거하였다. 해수면은 감지된 해수면 높이에서 파랑의 영향을 제거하여 지정하였다(Fig. 12 참조).

처오름 높이를 산정하기 이전에 영상의 원근감과 각도를 보정하기 위하여 식(1)과 같은 변환행렬 Mp를 갖는 원근변환(Perspective transformation)을 적용하였다.

여기서, (x,y)는 원본 영상의 픽셀 좌표, (x',y')는 행렬 Mp에 의해 투영되는 영상 픽셀의 좌표이며, w는 비례상수이다. Fig. 13은 원근변환을 적용하기 전의 원본 영상과 원근변환을 이용한 보정된 영상을 나타낸다.

실제 처오름 높이를 산정하기 위해 현장조사를 통해 CCTV영상 내의 구조물 높이 및 길이를 측정하였다. 측정된 구조물의 실제 높이와 영상 내의 픽셀 수를 비교하여 픽셀 당 실제 거리를 산정하였다. 영상에서 산정된 해수면과 이진 영상의 최대 높이의 차이를 구한 후 현장조사를 통해 취득한 픽셀 당 실제 거리를 대입하여 영상 내 처오름 높이를 산정한 후 원근변환을 역으로 적용하여 Fig. 14와 같이 처오름 높이를 산정하였다.

CCTV 영상을 이용한 월파 감지의 정확도를 분석하기 위해 다음의 식(2)의 정밀도와 식(3)의 재현율을 이용하여 평가하였다.

식(2) 및 식(3)에서 TP(True Positive)는 실제 월파가 발생한 상황에서 월파가 발생한 것으로 예측하는 옳은 검출, FP(False Positive)는 실제 월파가 발생하지 않은 상황에서 월파가 발생한 것으로 예측하는 틀린 검출, FN(False Negative)는 실제 월파가 발생한 상황에서 월파가 발생하지 않은 것으로 예측한 것을 뜻한다. 즉, 정밀도는 모든 검출 결과 중 옳게 검출한 비율을 의미하고, 재현율은 검출해야 하는 물체 중 제대로 검출된 것의 비율을 의미한다. 월파 유무와 위치를 수동으로 분류한 것을 정답 값이라 하고, 정답 값과 월파 감지 결과 박스의 크기와 위치의 IoU(Intersection Over Union)가 50%이상인 것을 True로, 나머지는 False로 지정하였다.

정밀도와 재현율은 임계값에 따라 값이 변화하며, 재현율이 증가할수록 정밀도는 낮아진다. 따라서, 객체탐지 알고리즘의 성능을 전반적으로 파악하기 위해 재현율 값(0.0, 0.1, ..., 1.0)들에 대응하는 정밀도 값들의 평균을 나타낸 P-R 곡선(Precision-Recall curve)을 주로 사용하며, Fig. 15에 P-R 곡선의 예시를 나타내었다. P-R 곡선은 어떤 알고리즘의 성능을 전반적으로 파악하기에는 좋으나 서로 다른 두 알고리즘의 성능을 정량적으로 비교하기에는 불편한 점이 있다. 이러한 문제점을 해결하기 위해 P-R 곡선의 면적을 정량적 지표로 사용하는 AP(Average Precision)를 동시에 사용하였다.

테스트로 사용한 영상은 야간과 악천후 영상이 포함된 실제 CCTV 영상 6개로 총 13,835 프레임이고, 정답 데이터는 수동으로 월파의 위치를 지정하여 구축하였다. 본 연구에서 사용한 객체탐지 알고리즘인 YOLOv3를 이용하여 COCO 데이터 셋 학습 결과 mAP(mean Average Precision) 55.3%로 나타났으나, 월파를 감지한 실험 결과에서는 59.6%로 산정되었고 P-R 곡선은 Fig. 16과 같이 나타났다. 성능향상을 위해 외부 데이터셋과 여과알고리즘을 적용하여 기존 실험보다 성능이 향상된 것으로 판단된다. 월파 감지 모델의 속도는 GPU(GeForce RTX 2080 TI) 기준 70fps로 실시간 감지에 적합한 정확도와 속도를 보였다.

전 세계적으로 가장 큰 이슈인 지구온난화 현상은 다양한 기상해양 현상변화와 태풍강도 증가로 연안에 내습하는 고파랑의 발생빈도 증가로 나타나고 있다. 이에 따른 월파 발생빈도 증가는 월파 관측 기술의 필요성에 대한 인식을 높이고 있다. 하지만, 기존의 월파 관측방식인 현장관측과 수리모형실험의 경우 많은 시간과 비용이 발생하고 연속적인 관측은 수행할 수 없어 월파와 관련된 관측 통계자료를 생산할 수 없었다. 또한, 영상분석만을 통한 월파 관측은 야간이나 악기상시에 월파를 정확하게 관측하기 어려운 문제를 가지고 있었다. 이에 본 연구에서는 월파를 실시간 자동으로 감지할 수 있는 시스템을 개발하였다.

본 연구에서 제안한 월파 감지 시스템은 실시간으로 악기상 및 야간에도 월파를 감지할 수 있음을 확인하였다. 특히, 합성곱 신경망과 영상분석 기술을 적용하여 실시간으로 CCTV 영상에서 파랑의 처오름을 감지하고 월파 여부를 판단하는 여과 알고리즘을 적용하여 월파의 발생 감지에 대한 정확성을 향상시켰다. 본 연구에서 제안한 월파 감지 시스템에서는 월파 발생 시 해당 영상을 자동으로 저장하고 월파고를 관측하여 데이터베이스로 구축할 수 있다. 특히, 구조물의 형상이나 입사파랑의 특성을 고려하지 않고 월파를 감지하고 처오름 높이를 산정할 수 있기 때문에 높은 확장성을 가지고 있다는 장점이 있다. 하지만, 처오름 높이 관측 값이 존재하지 않아 정량적 평가가 불가능하였고, 영상 내에 나타나는 처오름 높이를 추정하였다. 향후 수리모형실험 등으로 관측 값을 확보한 뒤 검증을 수행한다면 본 기술에 대한 신뢰성을 확보할 수 있을 것으로 예상된다. 또한, 본 연구에서는 제한된 CCTV 영상을 기반으로 월파 및 처오름을 감지하였지만 향후 CCTV 영상의 해상도 및 대상 구조물과의 위치관계 등에 따른 검출 알고리즘의 민감도 분석도 추가로 수행되어야 할 것으로 판단된다.

CCTV 영상을 통해 관측할 수 있는 정보는 월파 영상, 월파고, 월파의 발생 위치, 월파 발생빈도 등이며, 이러한 정보를 이용하여 관측구역에 있어서 월파의 위험 구간, 최대 월파고, 구조물에 따른 월파현상에 관한 실측된 자료를 산출할 수 있다. 월파 감지 기술을 해역별·연안구조물별로 적용하여 모니터링하고 데이터베이스를 축적한다면 다양한 월파 연구에 대한 기초자료를 제공할 수 있을 것이다. 앞으로 영상분석에 인공지능 기술을 활발하게 도입하여 해양분야에서도 다양하게 활용되길 기대한다.

Acknowledgments

이 논문은 2022년도 해양수산부 재원으로 해양수산과학기술진흥원의 지원을 받아 수행하는 “월파 정량 관측 기술 개발”(No.20220180, 해양 기후변화 진단 및 장기전망 연구) 및기상청 한국기상산업기술원 연구개발사업 “CCTV를 활용한지진해일 자동 관측 기술 개발(KMI2021-01010)”의 지원을 받아수행된 연구임을 밝힙니다.

References

[1] Bochkovskiy, A, Wang, C and Liao, H(2020), ““YOLOv4: Optimal Speed and Accuracy of Object Detection””, arXiv preprint arXiv, Vol. 2004, pp. 10934.

[2] Chi, S, Zhang, C, Sui, T, Cao, Z, Zheng, J and Fan, J(2021), ““Field observation of wave overtopping at sea dike using shore-based video images””, Journal of Hydrodynamics, Vol. 33, pp. 57-672.

[3] Choi, EH and Kim, C. S(2012), ““A Design of Disaster Prevention System and Detection of Wave Overtopping Number for Storm Surge base on CCTV””, Journal of Korea Multimedia Soiety, Vol. 15, No. 2, pp. 258-265.

[4] De Rouck, J, Troch, P., Van de Walle, B., van Gent, M., Van Damme, L., De Ronde, J., Frigaard, P and Murphy, J(2001), “Wave Run-up on Sloping Coastal Structures: Prototype Versus Scale Model Results”, Proc. Int. Conf. on Coastlines, Structures and Breakwaters 2001. Institution of Civil Engineers; London, UK: p. 26-28. Sept.;2001.

[5] De Rouck, J, Verhaeghe, H and Geeraerts, J(2009), ““Crest level assessment of coastal structures—General overview””, Coastal Engineering, Vol. 56, pp. 99-210.

[6] Girshick, R, Donahue, J, Darrell, T and Malik, J(2014), “Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation”, IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA: p. 580-587.

[7] Goda, Y, Kishiara, Y and Kamiyama, Y(1975), ““Laboratory Investigation on the Overtopping Rates for Seawalls by Irregular Waves””, Port and Harbour Research Institution, Vol. 14, pp. 3-44.

[8] Goda, Y(2009), ““Derivation of unified wave overtopping formulas for seawalls with smooth, impermeable surfaces based on selected CLASH datasets””, Coastal Engineering, Vol. 56, pp. 385-399.

[9] Haridas, R and Jyothi, RL(2019), ““Convolutional Neural Networks: A Comprehensive Survey””, International Journal of Applied Engineering Research, Vol. 14, pp. 780-789.

[10] LeCun, Y, Bottou, L, Bengio, Y and Haffner, P(1998), ““Gradient-Based Learning Applied to Document Recognition””, Proceedings of the IEEE, Vol. 86, pp. 2278-2324.

[11] Lee, YH and Kim, Y(2020), ““Comparison of CNN and YOLO for Object Detection””, Journal of the Semiconductor & Display Technology, Vol. 19, No. 1, pp. 85-92.

[12] Liu, W, Anguelov, D, Erhan, D, Szegedy, S, Reed, S, Fu, C and Berg, AC(2016), “SSD: Single Shot MultiBox Detector”, European Conference on Computer Vision. Amsterdam, Netherlands: Oct 8-16 p. 21-37.

[13] Ministry of Oceans and Fisheris(MOF)(2020), “Korea Design Standrard (KC Code KDS 64 10 10)”.

[14] MOIS, Ministry of the Interior and Safety(2020), ““Disaster Annual Report 2019””, pp. 431.

[15] Otsu, N(1979), ““A threshold selection method from gray-level histogram””, IEEE Trans on System Man Cybernetic, Vol. SMC-9, No. 1, pp. 62-66.

[16] Pullen, T, Allsop, N W. H., Bruce, T, Kortenhaus, A, Schüttrumpf, H and Van der Meer, JW(2007), “EurOtop wave overtopping of sea defences and related structures: assessment manual”.

[17] Redmon, J, Divvala, S, Girshick, R and Farhadi, A(2016), ““You Only Look Once Unified, RealTime Object Detection. Computer Vision and Pattern Recognition (CVPR)””, 2016 IEEE Conference, pp. 779-788.

[18] Redmon, J and Farhadi, A(2017), ““YOLO9000: Better, Faster, Stronger””, Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp. 7263-7271.

[19] Redmon, J and Farhadi, A(2018), ““YOLOv3: An Incremental Improvement””, arXiv preprint, pp. arXiv:1804.02767.

[20] Uijlings, J. R. R, Sande, K. E. A., Gevers, T and Smeulders, A. W. M(2013), ““Selective Search for Object Recognition””, International Journal of Computer Vision, Vol. 104, No. 2, pp. 154-171.

[21] Van der Meer, JW, Allsop, N. W. H., Bruce, T, De Rouck, J, Kortenhaus, A, Pullen, T, Schüttrumpf, H, Troch, P and Zanuttigh, B(2018), “Manual on Wave Overtopping of Sea Defenses and Related Structures— An Overtopping Manual Largely Based on European Research, But for Worldwide Application”.

- TOOLS

PDF Links

PDF Links PubReader

PubReader ePub Link

ePub Link Full text via DOI

Full text via DOI Download Citation

Download Citation Print

Print